네이버클라우드 실무사용법014 : 리눅스서버의 OS영역을 스냅샷 생성하여 다른서버의 추가스토리지로 생성하기

작성자 정보

- 관리자 작성

- 작성일

컨텐츠 정보

- 538 조회

- 0 추천

-

목록

본문

리눅스서버의 OS영역을 스냅샷 생성하여 다른서버의 추가스토리지로 생성하기

2번서버의 OS영역(기본스토리지) 스냅샷 생성하여 1번서버의 추가스토리지로 생성하기

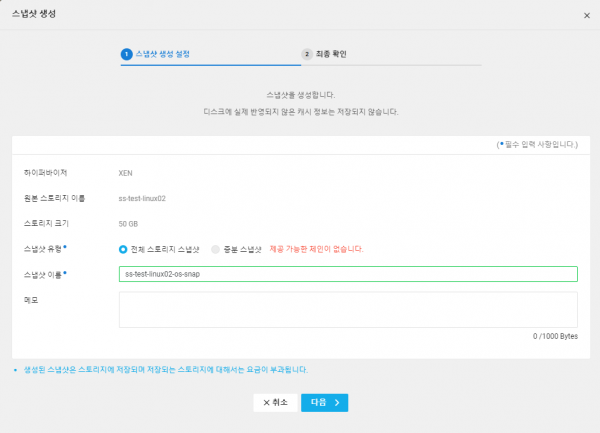

1. 2번서버의 기본스토리지 스냅샷 생성

Server > Storage > “2번리눅스서버의 기본스토리지 선택” > “스토리지 설정” > 스냅샷생성

2. 스토리지 스냅샷 생성 확인

Server > Snapshot > 생성된 스냅샷 확인

3. 생성한 스냅샷으로 스토리지 생성

Server > Snapshot > 생성한 스냅샷 선택(ss-test-linux02-os-snap) > +스토리지생성 >

.스토리지

이름 : ss-linux01-snap-disk

.Zone : KR-2

.스토리지종류 : HDD

.서버선택 :

ss-test-linux01

.크기 : 50GB

이렇게 하면… linux01 서버에서 (2번서버의 os영역 스냅샷으로 생성한)스토리지를 확인할 수 있다.

4. UUID 중복으로 에러발생 및 해결하기

리눅스1번에 ssh로 원격접속하여 마운트를 진행하면 다음과 같이 오류 발생한다.

원인은 UUID 중복 때문이다.

다음은 리눅스1번서버에서 lsblk로 방금 추가한 스토리지가 xvde에 할당되어 있는 것을 확인할 수있다.

|

[root@ss-test-linux01 ~]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT xvda 202:0 0 50G 0 disk ├─xvda1 202:1 0 1G 0 part /boot └─xvda2 202:2 0 49G 0 part / xvdb 202:16 0 20G 0 disk └─xvdb1 202:17 0 10G 0 part xvdc 202:32 0 10G 0 disk └─xvdc1 202:33 0 10G 0 part └─lvmVG-lvmLV 253:0 0 20G 0 lvm /lvm xvdd 202:48 0 10G 0 disk └─xvdd1 202:49 0 10G 0 part └─lvmVG-lvmLV 253:0 0 20G 0 lvm /lvm xvde 202:64 0 50G 0 disk ├─xvde1 202:65 0 1G 0 part └─xvde2 202:66 0 49G 0 part [root@ss-test-linux01 ~]# |

마운트 에러 발생

|

[root@ss-test-linux01 ~]# mkdir /disk2 [root@ss-test-linux01 ~]# [root@ss-test-linux01 ~]# mount /dev/xvde2 /disk2 mount: /disk2: wrong fs type, bad option, bad superblock on /dev/xvde2, missing codepage or helper program, or other error. [root@ss-test-linux01 ~]# |

UUID 리스트 확인하기

모든 디스크에 할당된 UUID를 다음과 같이 확인해 보면.. 아래와 같이 UUID가 중복되어 있음을 알수 있다.

|

[root@ss-test-linux01 ~]# blkid /dev/xvda1: UUID="d95e3752-8d43-4af3-898e-4d312facf522" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-01" /dev/xvda2: UUID="c78179f8-fbff-456e-b77c-26010001fee6" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-02" /dev/xvdb1: UUID="7c361dc3-e3b0-419f-bc20-62f8988340c5" BLOCK_SIZE="4096" TYPE="ext4" PARTUUID="0ee5a53a-01" /dev/xvdc1: UUID="FPE0Lo-do8a-wGLv-jfUN-oRRh-tVEm-QKIx7r" TYPE="LVM2_member" PARTUUID="859e840e-01" /dev/xvdd1: UUID="zEtlDR-XbKK-vT8K-7Czx-FXvT-6D0q-00PI5E" TYPE="LVM2_member" PARTUUID="ed2907f4-01" /dev/mapper/lvmVG-lvmLV: UUID="20626e48-ada7-4ead-b6e7-38d290d093ee" BLOCK_SIZE="4096" TYPE="ext4" /dev/xvde1: UUID="d95e3752-8d43-4af3-898e-4d312facf522" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-01" /dev/xvde2: UUID="c78179f8-fbff-456e-b77c-26010001fee6" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-02" [root@ss-test-linux01 ~]# |

UUID 생성하기

|

[root@ss-test-linux01 ~]# uuidgen a1414656-a4d0-4c9a-bec0-f8bd74c210e1 [root@ss-test-linux01 ~]# |

|

[root@ss-test-linux01 ~]# xfs_repair -L /dev/xvde2 Phase 1 - find and verify superblock... Phase 2 - using internal log - zero log... - scan filesystem freespace and inode maps... - found root inode chunk Phase 3 - for each AG... - scan and clear agi unlinked lists... - process known inodes and perform inode discovery... - agno = 0 - agno = 1 - agno = 2 - agno = 3 - process newly discovered inodes... Phase 4 - check for duplicate blocks... - setting up duplicate extent list... - check for inodes claiming duplicate blocks... - agno = 0 - agno = 1 - agno = 2 - agno = 3 Phase 5 - rebuild AG headers and trees... - reset superblock... Phase 6 - check inode connectivity... - resetting contents of realtime bitmap and summary inodes - traversing filesystem ... - traversal finished ... - moving disconnected inodes to lost+found ... Phase 7 - verify and correct link counts... Maximum metadata LSN (7:11369) is ahead of log (1:2). Format log to cycle 10. done [root@ss-test-linux01 ~]# |

UUID 재 설정하기

생성한 UUID를 /dev/xvde2 에 다음과 같이 할당한다.

|

[root@ss-test-linux01 ~]# xfs_admin -U a1414656-a4d0-4c9a-bec0-f8bd74c210e1 /dev/xvde2 Clearing log and setting UUID writing all SBs new UUID = a1414656-a4d0-4c9a-bec0-f8bd74c210e1 [root@ss-test-linux01 ~]# [root@ss-test-linux01 ~]# blkid /dev/xvda1: UUID="d95e3752-8d43-4af3-898e-4d312facf522" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-01" /dev/xvda2: UUID="c78179f8-fbff-456e-b77c-26010001fee6" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-02" /dev/xvdb1: UUID="7c361dc3-e3b0-419f-bc20-62f8988340c5" BLOCK_SIZE="4096" TYPE="ext4" PARTUUID="0ee5a53a-01" /dev/xvdc1: UUID="FPE0Lo-do8a-wGLv-jfUN-oRRh-tVEm-QKIx7r" TYPE="LVM2_member" PARTUUID="859e840e-01" /dev/xvdd1: UUID="zEtlDR-XbKK-vT8K-7Czx-FXvT-6D0q-00PI5E" TYPE="LVM2_member" PARTUUID="ed2907f4-01" /dev/mapper/lvmVG-lvmLV: UUID="20626e48-ada7-4ead-b6e7-38d290d093ee" BLOCK_SIZE="4096" TYPE="ext4" /dev/xvde1: UUID=" d95e3752-8d43-4af3-898e-4d312facf522" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-01" /dev/xvde2: UUID="a1414656-a4d0-4c9a-bec0-f8bd74c210e1" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-02" [root@ss-test-linux01 ~]# |

다시 마운트 하기

이번에는 UUID가 중복되지 않았기 때문에 마운트가 정상적으로 수행된다.

|

[root@ss-test-linux01 ~]# mount /dev/xvde2 /disk2

[root@ss-test-linux01 ~]# |

마운트 정보 확인하기

. lsblk 또는 df로

마운트된 것을 확인한다.

|

[root@ss-test-linux01 ~]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT xvda 202:0 0 50G 0 disk ├─xvda1 202:1 0 1G 0 part /boot └─xvda2 202:2 0 49G 0 part / xvdb 202:16 0 20G 0 disk └─xvdb1 202:17 0 10G 0 part xvdc 202:32 0 10G 0 disk └─xvdc1 202:33 0 10G 0 part └─lvmVG-lvmLV 253:0 0 20G 0 lvm /lvm xvdd 202:48 0 10G 0 disk └─xvdd1 202:49 0 10G 0 part └─lvmVG-lvmLV 253:0 0 20G 0 lvm /lvm xvde 202:64 0 50G 0 disk ├─xvde1 202:65 0 1G 0 part └─xvde2 202:66 0 49G 0 part /disk2 [root@ss-test-linux01 ~]# [root@ss-test-linux01 ~]# df Filesystem 1K-blocks Used Available Use% Mounted on devtmpfs 1881300 0 1881300 0% /dev tmpfs 1899800 0 1899800 0% /dev/shm tmpfs 1899800 8708 1891092 1% /run tmpfs 1899800 0 1899800 0% /sys/fs/cgroup /dev/xvda2 51354116 3843180 47510936 8% / /dev/xvda1 1038336 257140 781196 25% /boot tmpfs 379960 0 379960 0% /run/user/0 /dev/mapper/lvmVG-lvmLV 20503120 45080 19393492 1% /lvm /dev/xvde2 51354116 3613388 47740728 8% /disk2 [root@ss-test-linux01 ~]# |

Disk2 디렉토리에서 기존 내용 확인하기

리눅스2번서버의 os영역스냅샷으로 생성한 스토리지를 리눅스1번서버에 추가한 것이기 때문에 기존 내용이 그대로 보인다.

|

[root@ss-test-linux01 ~]# ls -l /disk2 total 20 lrwxrwxrwx. 1 root root 7 Oct 11 2021 bin -> usr/bin drwxr-xr-x. 2 root root 6 Sep 30 2022 boot drwxr-xr-x. 2 root root 6 Sep 30 2022 dev drwxr-xr-x. 102 root root 8192 Aug 16 15:48 etc drwxr-xr-x. 3 root root 20 Aug 16 13:51 home drwxr-xr-x 3 root root 20 Nov 4 2022 home1 lrwxrwxrwx. 1 root root 7 Oct 11 2021 lib -> usr/lib lrwxrwxrwx. 1 root root 9 Oct 11 2021 lib64 -> usr/lib64 drwxr-xr-x 2 root root 48 Aug 16 17:38 lost+found drwxr-xr-x. 2 root root 6 Oct 11 2021 media drwxr-xr-x. 2 root root 6 Oct 11 2021 mnt drwxr-xr-x. 2 root root 6 Oct 11 2021 opt drwxr-xr-x. 2 root root 6 Sep 30 2022 proc dr-xr-x---. 2 root root 112 Nov 4 2022 root drwxr-xr-x. 2 root root 6 Sep 30 2022 run lrwxrwxrwx. 1 root root 8 Oct 11 2021 sbin -> usr/sbin drwxr-xr-x. 2 root root 6 Oct 11 2021 srv drwxr-xr-x. 2 root root 6 Sep 30 2022 sys drwxrwxrwt. 9 root root 4096 Aug 16 17:22 tmp drwxr-xr-x. 13 root root 158 Sep 30 2022 usr drwxr-xr-x. 21 root root 4096 Sep 30 2022 var [root@ss-test-linux01 ~]# |

새로 생성한UUID를 추가한 디스크파티션에 할당한다.

|

[root@ss-test-linux01 ~]# xfs_admin -U a1414656-a4d0-4c9a-bec0-f8bd74c210e1 /dev/xvde2 Clearing log and setting UUID writing all SBs new UUID = a1414656-a4d0-4c9a-bec0-f8bd74c210e1 [root@ss-test-linux01 ~]# |

추가로 UUID가 중복되어 있는 /dev/xvde1 파티션도 새롭게 UUID를 할당해준다.

|

[root@ss-test-linux01 ~]# uuidgen 21c5f5d6-b6a4-4010-9403-00f442b2de58 [root@ss-test-linux01 ~]# [root@ss-test-linux01 ~]# xfs_admin -U 21c5f5d6-b6a4-4010-9403-00f442b2de58 /dev/xvde1 Clearing log and setting UUID writing all SBs new UUID = 21c5f5d6-b6a4-4010-9403-00f442b2de58 [root@ss-test-linux01 ~]# [root@ss-test-linux01 ~]# blkid /dev/xvda1: UUID="d95e3752-8d43-4af3-898e-4d312facf522" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-01" /dev/xvda2: UUID="c78179f8-fbff-456e-b77c-26010001fee6" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-02" /dev/xvdb1: UUID="7c361dc3-e3b0-419f-bc20-62f8988340c5" BLOCK_SIZE="4096" TYPE="ext4" PARTUUID="0ee5a53a-01" /dev/xvdc1: UUID="FPE0Lo-do8a-wGLv-jfUN-oRRh-tVEm-QKIx7r" TYPE="LVM2_member" PARTUUID="859e840e-01" /dev/xvdd1: UUID="zEtlDR-XbKK-vT8K-7Czx-FXvT-6D0q-00PI5E" TYPE="LVM2_member" PARTUUID="ed2907f4-01" /dev/mapper/lvmVG-lvmLV: UUID="20626e48-ada7-4ead-b6e7-38d290d093ee" BLOCK_SIZE="4096" TYPE="ext4" /dev/xvde1: UUID="21c5f5d6-b6a4-4010-9403-00f442b2de58" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-01" /dev/xvde2: UUID="a1414656-a4d0-4c9a-bec0-f8bd74c210e1" BLOCK_SIZE="512" TYPE="xfs" PARTUUID="c0214863-02" [root@ss-test-linux01 ~]# |

앞전에서는 /dev/xvda1과 /dev/xvde1의 UUID가 중복되어 있었으나 이번에는 중복되지 않았음을 확인할 수 있다.

이렇게 UUID 중복문제를 완벽하게 해결 하였다.

관련자료

-

이전

-

다음