자격증 분류

NCE 자격증 이론정리 63편- Analytics 분야 - Hadoop의 구성요소

작성자 정보

- 관리자 작성

- 작성일

컨텐츠 정보

- 461 조회

- 0 추천

- 목록

본문

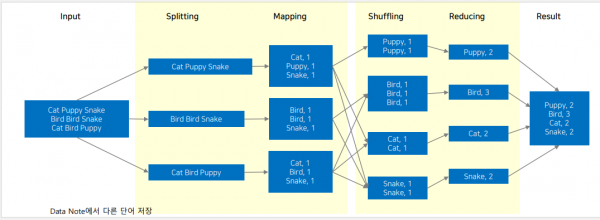

Hadoop

Core 구성요소

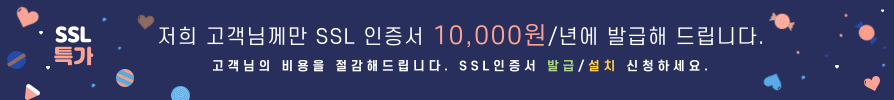

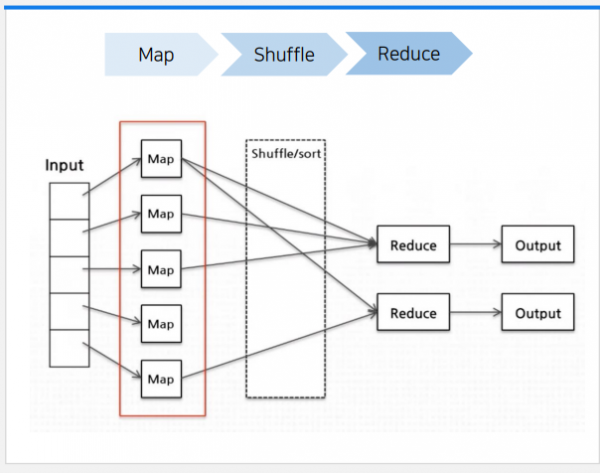

-Map + Reduce

-구글이 수집한

문서와 로그등 방대한 데이터들을 분석하기 위해 2004년에 발표

-방대한 양의 데이터를 노드에

병렬화하여 처리하기 위한 프레임워크

-Map : 정렬되지 않은

데이터를 속성이 같은 Key-value형태로 연관성있는 데이터 분류로 묶는 작업. 즉 데이터를 튜플(key와 value의

쌍) 형태로 나누어 데이터셋 변환

-Shuffle : 중간 결과를

리듀스로 전달

-Reduce : 리스트에서 원하는 데이터를 찾아서 집계. 즉 Map의 결과를 받아서 Key와 Value의 쌍을 더 작은 튜플 집합으로 집계

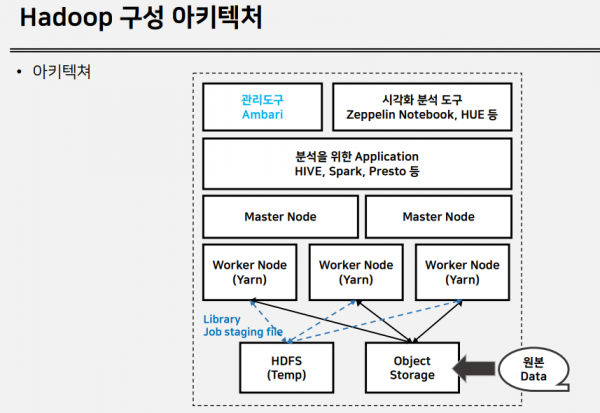

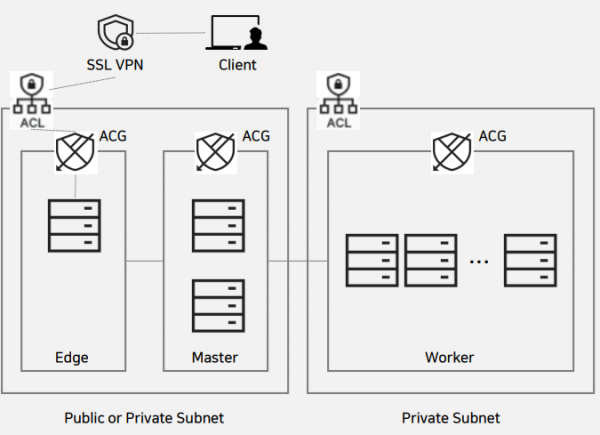

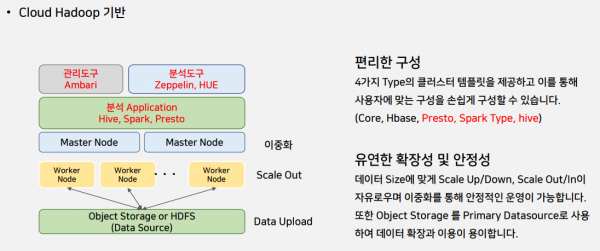

네이버 Cloud Hadoop 아키텍처

-외부 접속을 위한 Edge Node를 별도 제공하여 클러스터 접근 보안성을 높이고 있다.

-Hadoop Cluster에 접근하기 위해서는 Edge Node에 접속해야 하며, 이때는 SSL VPN을 통해 접근이 가능하다.

-Master Node는 2대가 기본으로 제공

-Worker Node는 최소 2대부터 8대까지 생성가능

-각노드의 스토리지 용량은 100GB ~ 2TB/4TB/6TB로 생성가능

"무단배포금지: 클라우드포털(www.linux.co.kr)의 모든 강좌는 저작권에 의해 보호되는 콘텐츠입니다. 무단으로 복제하여 배포하는 행위는 금지되어 있습니다."

관련자료

-

이전

-

다음

댓글 0

등록된 댓글이 없습니다.